Директива Sitemap в robots.txt – это ссылка на файл Sitemap, в котором собраны все страницы сайта для индексирования. Она позволяет сообщить роботу поисковой системы о наличии карты сайта, указать путь к XML файлу и начать индексировать его.

Указывать расположение файла Sitemap.XML необходимо, если для описания структуры ресурса используется карта сайта. Их может быть несколько, тогда нужно прописать их все.

Пример файла Robots с указанием пути к Sitemap:

User-agent: *

Disallow: /page

Sitemap: https://www.example.com/sitemap.xmlПример robots.txt с указанием нескольких адресов карты сайта:

User-agent: *

Allow: /

Sitemap: https://site.ru/site_structure/sitemap1.xml

Sitemap: https://site.ru/site_structure/sitemap2.xmlПравило Sitemap является межсекционным, а это значит, что поисковый бот будет использовать директиву независимо от того, где она прописана в файле robots.txt.

Можно данную директиву Sitemap прописывать и через пустую строку. Пример:

User-agent: *

Allow: /

User-agent: Yandex

Dissalow: /

Sitemap: https://site.ru/site_structure/sitemap2.xmlРобот запомнит указанное расположение файла, обработает информацию и начнет применять результаты с того момента, когда снова будет формировать сессии загрузки.

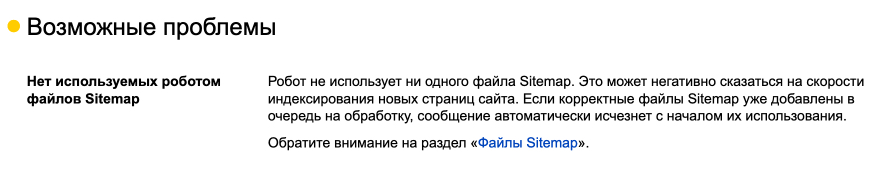

Указание Sitemap рекомендуется использовать в Robots.txt, потому что им активно пользуются Google, Яндекс. Если вы не указываете данную директиву, то в Яндекс Вебмастер отображается предупреждение об этом.

Доброго времени! Купил на телдери сайт.

В роботс прописано вот так:

Disallow:

Sitemap: https://site.ru/sitemap.xml

И яша выдает это:

Страница неизвестна роботу.Если она должна попасть в поиск, сообщите об этом роботу, добавив ее в Sitemap. Другие способы помочь роботу узнать о страницах.

Я уже припарился сращивать че за ерунда.

Как правильно прописать?

Добавьте ссылку на сайтмап в вебмастер яндекса.

Здравствуйте! А если такая ссылка есть, однако при добавлении новых страниц выдает такое же сообщение: «Страница неизвестна роботу. Чтобы робот быстрее узнал о ней, включите обход по счётчику Метрики и добавьте страницу в Sitemap» — при этом счетчик привязан, а также: «Страница обходится роботом, но отсутствует в поиске».

ну так Дисалов выше запрещает индексацию? в том числе и файл ситимап

Доброго времени суток. WordPress у меня не в корне сайта.

По ссылке domen.ru/wp-sitemap.xml расположено 5 XML-карт. Непонятно: в robots.txt в корне сайта прописать эту 1 карту в которой 5 ссылок на все карты или в robots.txt надо прописать все 5 ссылок?

Одну

Добрый день.

Получается, раз правило Sitemap.xml является межсекционным, то можно не указывать его в списке правил для каждого робота по отдельности, а указать один раз в любом месте файла robots.txt, верно?

Добрый, да, все верно

Почему-то Гугля даже скушав карту не желает индексировать домен

Должен ли Гугл сам втаскивать указанный в роботсе сайтмап в гугл консоль? Вроде же да, вроде раньше и втаскивал как и Яндекс, но что-то сейчас не втаскивает.

в документации он пишет «Вставьте в любом месте файла robots.txt строку с путем к файлу Sitemap (она будет обнаружена при следующем сканировании файла robots.txt)». Она обнаружена, но файл сайтмапа в гугл-консоли не появился.

День добрый! А если на сайте 10 сайтмапов, то их тоже в роботс все надо указывать?